Главное меню

Вы здесь

Checkpoint и кластеризация

Источник:

https://www.youtube.com/watch?v=8vMkZZZCZl4

Объединение двух Checkpoint в кластер позволяет обеспечить работу системы при сбое одной из нод этого кластера.

В общем понимании кластер должен обладать следующими свойствами:

1) Redundancy - В кластере должно быть избыточное количество нод

2) Transparent - переключение в случае сбоя должно быть прозрачно для пользователя

3) Fault Tolerance - в случае сбоя переключение должно происходить автоматически

Checkpoin предлагает несколько clustering solutions:

- ClusterXL

- VRRP

ClusterXL

ClusterXL - проприетарное clustering solutions

ClusterXL может обеспечиваться двумя методами:

- High Availability - В кластере две или более ноды. Одна из них имеет Active status, вторая Standby status.

HA имеет две mode:

- Legacy mode HA (обычно не используется (основан на VRRP))

- New HA mode (поддерживается и используется) - Load Sharing / Load Balancing - В кластере также две или более ноды. Но обе ноды имеют Active status. Все ноды способны обрабатывать трафик, и способны распределять нагрузку.

- Unicast mode (простой метод)

- Multicast mode (более эффективный метод)

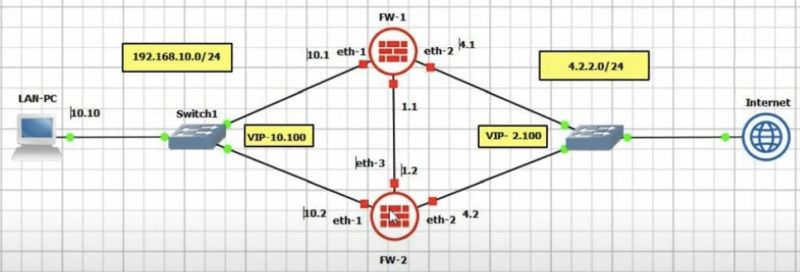

Во всех случаях каждая нода имеет свой IP адрес данного VLAN + один виртуальный IP, который является шлюзом для клиентов.

В случае HA виртуальный висит на Active node.

В случае Load Sharing / Load Balancing трафик попадает на виртуальный IP и далее балансируется между двумя нодами.

ClusterXL Basic requirements

- Железо должно совпадать с точностью до серии (например 4200 будет работать с 4400)

- OS на обоих нодах должна совпадать (например gaia)

- Версия OS должна совпадать

- HotFix на обоих нодах должны совпадать

- Аналогичные Blades настроенные на обоих нодах

- Синхронизация времени на обоих нодах. Использование NTP

State synchronization

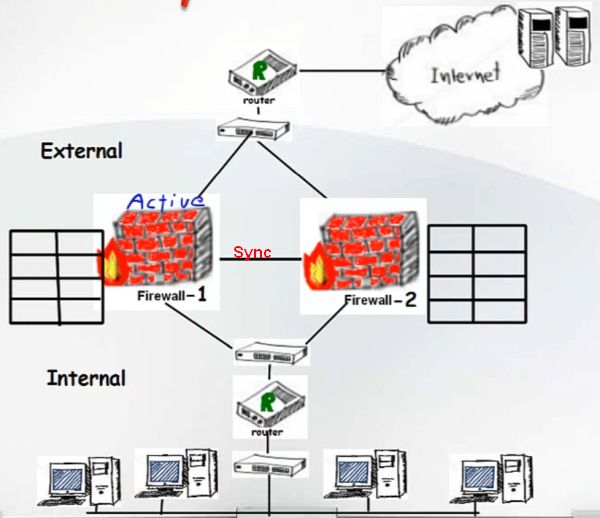

Для обеспечения прозрачности переключения в случае сбоя, все ноды кластера должны друг с другом синхронизироваться - State synchronization.

При State synchronization все ноды кластера "знают" все текущие connections.

Для обеспечения State synchronization используется Sync cable, который соединяет ноды кластера непосредственно или через коммутатор.

Существует два типа State synchronization:

- Full synchronization - Полная синхронизация подразумевает полноую загрузку всего Connection Table. Full synchronization происходит в случае ребута или присоединении ноды к кластеру

- Delta synchronization - Частичная синхронизация - происходит во время работы всех нод и синхронизирует вновь появляющиеся различия в Connection Table.

Cluster Control Protocol

Cluster Control Protocol или Checkpoint Control Protocol работает на всех интерфейсах, где мы включили кластеризацию.

CCP использует:

- Health Status Reports. Keepalive meassages - проверка доступности нод

- State change commands - при смене состояний active/standby

- Cluster member probing

- querying for cluster membership

- Kernel state tables

Cluster status

ноды в кластере могут находиться в следующих состояниях:

- Active

- Standby - пассивно слушает трафик от active. При необходимости становится Active.

- Down - администативно или какие то проблемы

- Active Attention - если нода последняя в Active state, и у нее проблемы. А все остальные ноды недоступны.

- Ready - разные версии софта, или разное железо

- Intializing - идет после ready, затем состояние станет Active или Standby

- ClusterXL inactive or machine down - случай когда одна из нод умерла.

Настройка ClusterXL HA

Источник https://www.youtube.com/watch?v=FRcck23stCE

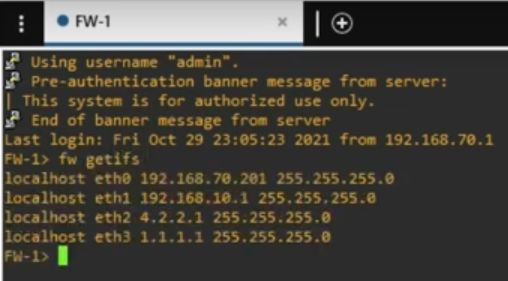

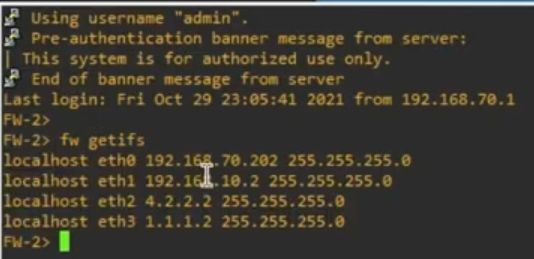

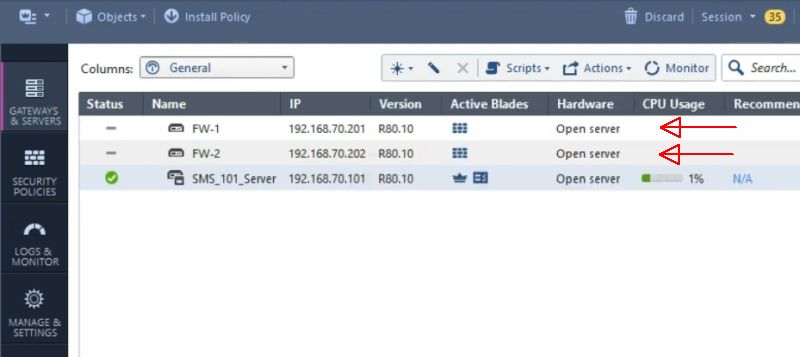

Добавляем два фаервола как показано на видео

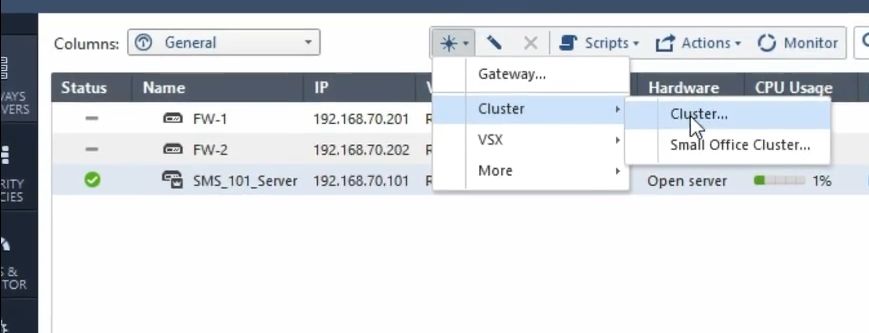

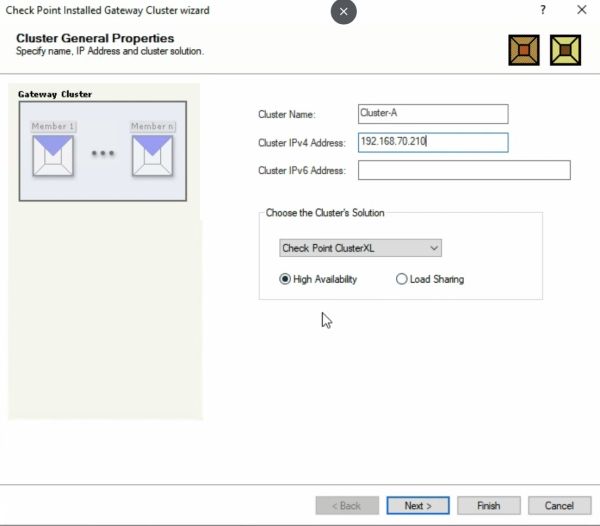

Далее добавляем кластер

Wizard mode

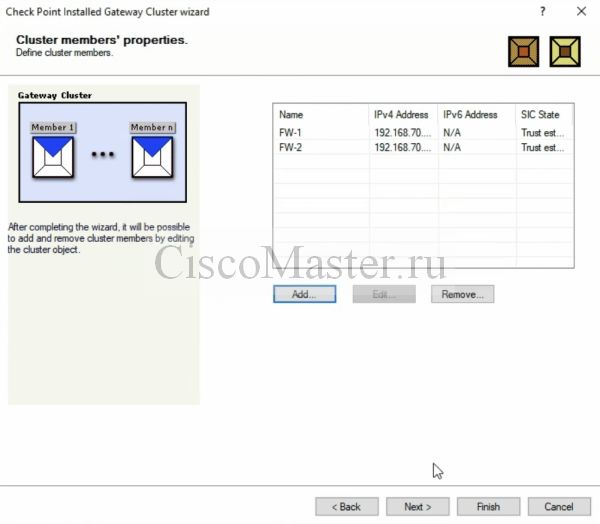

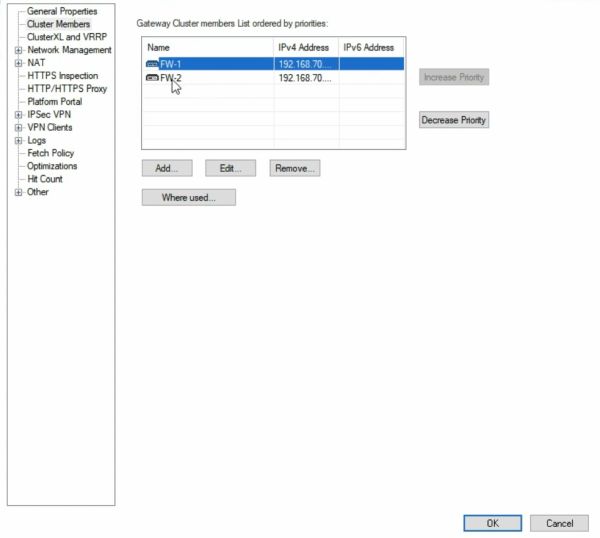

Добавляем Cluster memebers:

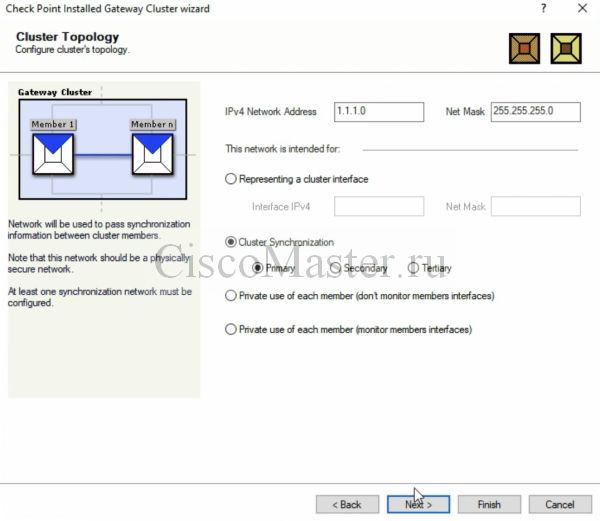

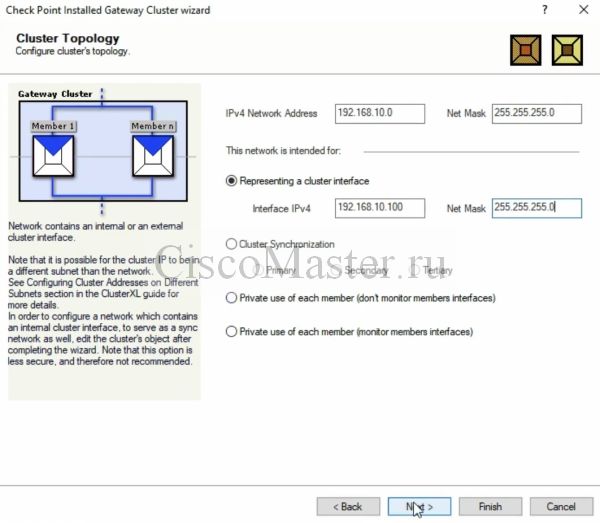

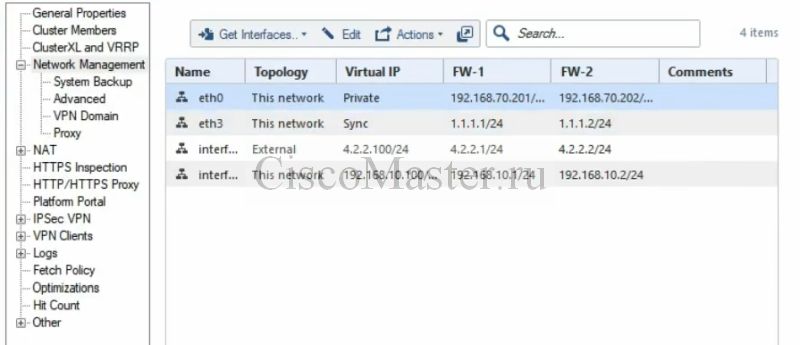

Настраиваем внешний IP кластера:

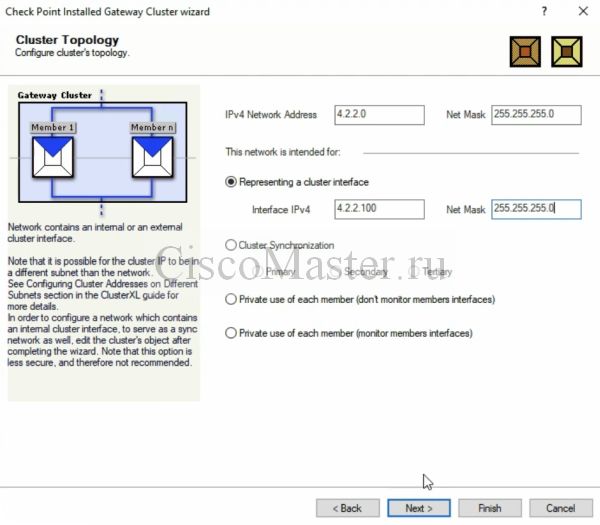

Настраиваем внутренний IP кластера:

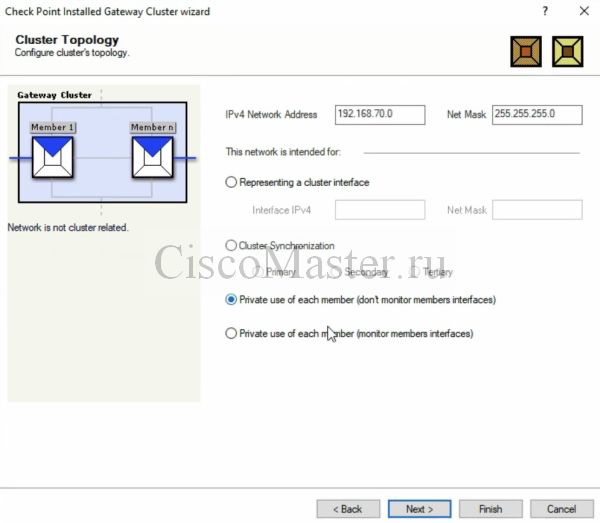

Сеть 192.168.70.0 является Management, поэтому нет необходимости включать на ней CCP

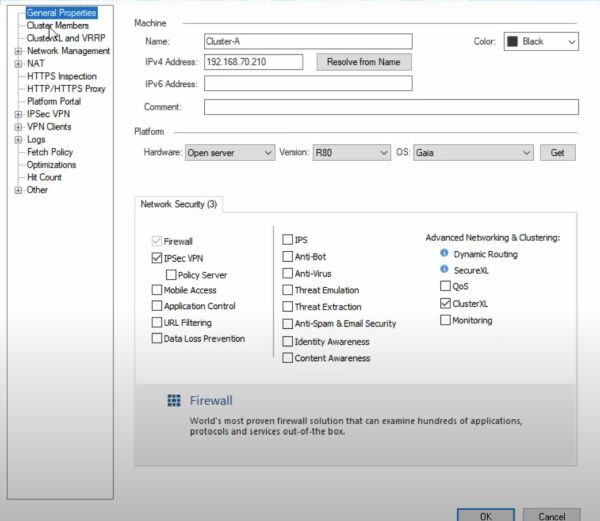

После создания кластера:

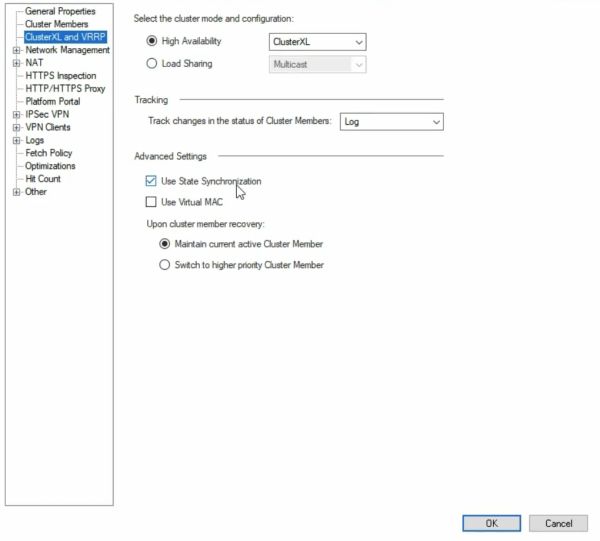

Если кликнуть на кластер, его основные настройки:

Далее делаем Publish, Install database, install Policy

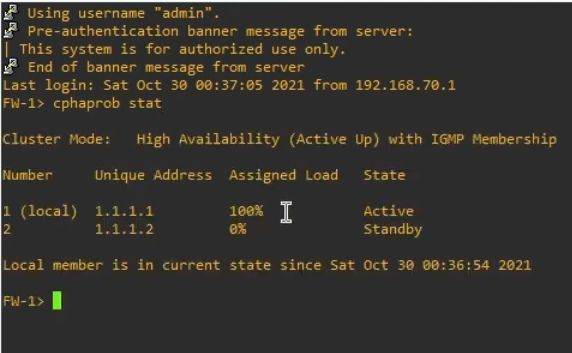

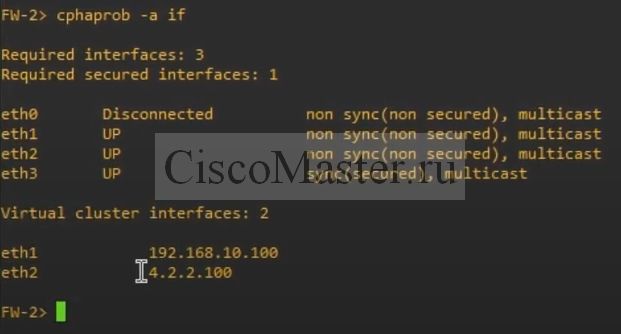

Проверка

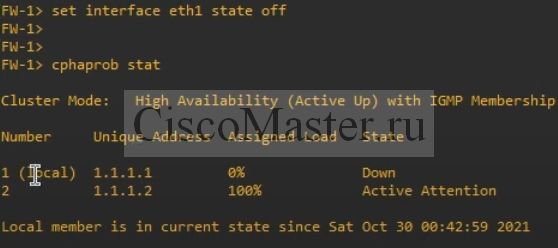

Для теста отключим внутренний интерфейс

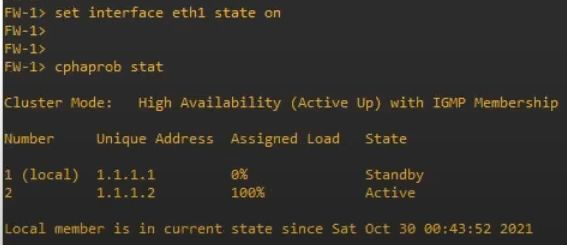

После включения всё вернется обратно

Комментарии

А соединить clusterxl с vrf

А соединить clusterxl с vrf есть такие же шаги по настройки ?

Добавить комментарий